Por qué 32 GB de RAM debería ser el nuevo estándar para PC para juegos

¿Qué es RAM?

RAM, abreviatura de Random Access Memory, es una parte de tu PC que almacena datos a los que su sistema necesita para acceder rápidamente. A diferencia de un disco duro o SSD, la RAM solo contiene datos mientras el equipo está encendido. Una vez que se apaga, se borra y se reinicia.

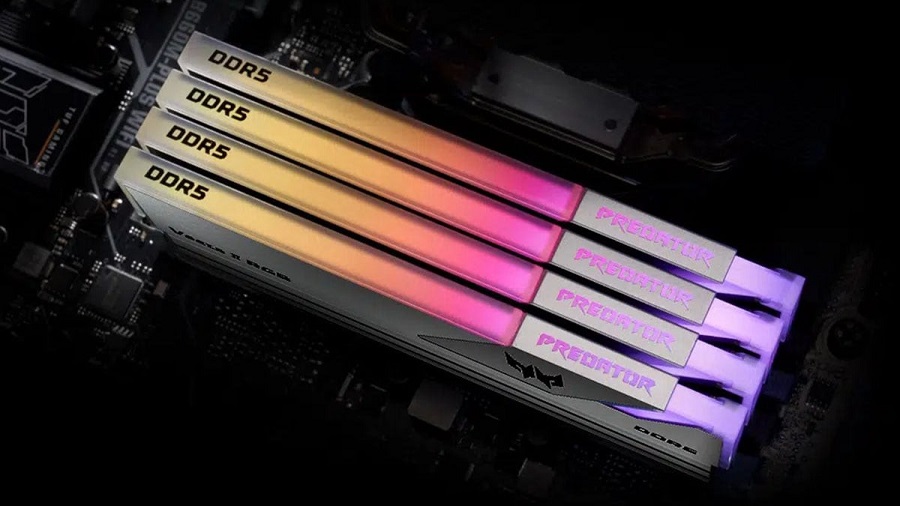

Hay varios tipos de RAM, siendo DDR (Double Data Rate) el más común. Hoy en día, la mayoría de los sistemas utilizan DDR4 o la nueva memoria DDR5. Aquí hay un desglose básico:

- DDR4: Fiable y todavía ampliamente utilizado, pero más lento en comparación con las opciones más nuevas.

- DDR5: Velocidades más rápidas, mayor ancho de banda y mejor eficiencia. Ideal para PC para juegos que se están construyendo o actualizando hoy.

La actualización a DDR5 proporciona mejores tiempos de carga, un juego más fluido y un mejor rendimiento al realizar múltiples tareas o ejecutar aplicaciones pesadas.

¿Por qué es importante la RAM para tu PC y juegos?

“La RAM juega un papel clave en lo bien que tu PC maneja juegos y programas. Funciona manteniendo los datos importantes listos para su CPU y GPU. Cuando juegas, la RAM carga texturas, modelos, sonidos y otros activos que el sistema necesita rápidamente”, explica Igal Daniels, Business Manager de Acer.

Señala que, no tener suficiente RAM, puede causar varios problemas:

- Tiempos de carga más lentos: Los juegos pueden tardar más en cargar niveles o menús.

- Caídas de rendimiento: las velocidades de fotogramas pueden caer durante las escenas concurridas.

- Tartamudeo: Los juegos pueden congelarse por períodos cortos mientras el sistema intenta obtener los archivos necesarios.

- Ralentización del sistema: Los programas en segundo plano, como Discord y los navegadores, pueden comenzar a arrastrar todo su sistema hacia abajo si la RAM se agota.

La RAM es el puente que mantiene su procesador y tarjeta gráfica funcionando a toda velocidad sin tener que extraer datos de unidades de almacenamiento más lentas.

¿Qué ocurre durante una partida si no tienes suficiente RAM?

Si juegas a un juego exigente y no tienes suficiente RAM, tu sistema tendrá problemas. Windows intentará descargar datos al archivo de paginación, que forma parte de tu SSD o disco duro. “Estamos hablando de asegurar que el equipo tenga la capacidad de ejecutar múltiples procesos simultáneamente, lo que es especialmente útil cuando se juega mientras se tienen otras aplicaciones abiertas o se ejecutan tareas en segundo plano. Además, si tu equipo tiene suficiente RAM, los juegos y programas gráficos cargan más rápido y funcionan de manera más fluida. Pero, independientemente de la velocidad de tu almacenamiento, sigue siendo mucho más lento que la RAM”, insiste Daniels.

Esto es lo que podrías experimentar:

- Torpeteo y picos de velocidad: El juego tiene dificultades para cargar texturas y recursos con la suficiente rapidez, lo que provoca una velocidad de fotogramas irregular y caídas repentinas del rendimiento.

- Tiempos de carga más largos: Los niveles y las texturas se cargan más lentamente, a veces a mitad de la partida, lo que interrumpe la inmersión.

- Ralentización del sistema: Windows traslada las tareas menos críticas al archivo de paginación, mucho más lento (almacenado en tu SSD), lo que provoca caídas de rendimiento considerables al usar Alt+Tab o al intentar la multitarea.

En juegos pesados como Hogwarts Legacy o The Last of Us Part I, correr con solo 16 GB de RAM a menudo conduce a tartamudeo de travesía, ventanas emergentes de activos y una experiencia de juego menos pulida en general.

¿Qué impulsó el aumento del uso de RAM en los juegos?

Los juegos actuales utilizan más RAM que antes por varias razones. Motores de juego como Unreal Engine 5 introducen nueva tecnología que carga modelos e iluminación más detallados. Los desarrolladores están diseñando mundos de juego más grandes y complejos, y esperan que los jugadores tengan sistemas más potentes.

Algunos de los factores clave incluyen:

- Características de Unreal Engine 5: Los juegos creados con Unreal Engine 5, como Marvel Rivals, ahora utilizan tecnologías complejas como Nanite y Lumen, ambas con un consumo de RAM extremadamente alto.

- Trazado de rayos: Las técnicas avanzadas de iluminación y reflexión cargan recursos pesados en la memoria, lo que requiere más recursos del sistema incluso con configuraciones medias.

- Texturas de mayor resolución: Las texturas 4K y los recursos grandes de mundo abierto necesitan espacio adicional.

- Multitarea en segundo plano: Los jugadores actuales suelen transmitir, usar Discord y ver videos mientras juegan, todo lo cual consume la RAM disponible.

- Menor optimización: Los juegos modernos suelen asumir que los jugadores tienen recursos suficientes, lo que lleva a los desarrolladores a establecer requisitos mínimos más altos sin tanta optimización.

Juegos como Hogwarts Legacy, Marvel Rivals o Indiana Jones and the Great Circle son claros ejemplos donde 16 GB de RAM ya no son suficientes para una experiencia fluida en configuraciones altas.

Por qué 32 GB deberían ser el nuevo estándar

Según pruebas realizadas con numerosos títulos modernos, 32 GB de RAM ofrecen una gran ventaja sin suponer un desperdicio. Te prepara para los juegos AAA actuales y para los próximos años de nuevos lanzamientos sin gastar una fortuna.

Estas son las razones por las que 32 GB son una buena opción:

- Margen de maniobra para hoy y para el futuro: Si bien 16 GB todavía permiten ejecutar muchos juegos «técnicamente», a menudo son apenas suficientes, especialmente porque títulos como Star Wars Jedi: Survivor y Hogwarts Legacy consumen más de 20 GB al incluir las tareas en segundo plano.

- Mejoras de rendimiento: Las pruebas demuestran que actualizar de 16 GB a 32 GB puede ofrecer beneficios tangibles. En Marvel Rivals, la velocidad de fotogramas mejoró alrededor de un 40 % con solo cambiar a 32 GB de RAM. Incluso juegos más antiguos como Helldivers 2 mostraron mejoras.

- Precio asequible: Los precios de la memoria DDR5 han bajado drásticamente. Se puede encontrar un buen kit de 32 GB DDR5-6000 por tan solo 75-90 USD, apenas un 25 % más que los kits de 16 GB, pero con el doble de capacidad.

- Mejor multitarea: Si ejecutas Discord, Chrome, OBS o aplicaciones en segundo plano mientras juegas, 32 GB evitan ralentizaciones causadas por el intercambio de archivos de paginación.

- A prueba de futuro: Con los desarrolladores superando los límites tecnológicos y la creciente popularidad de Unreal Engine 5, tener 32 GB garantiza que tu sistema no se llene de datos con futuras versiones.

Actualmente, una configuración de 16 GB sigue ejecutando muchos juegos sin problemas, pero el margen de maniobra es limitado. Los nuevos lanzamientos solo aumentarán las necesidades de memoria. Por esta razón, actualizar a una configuración de 32 GB de RAM no solo mejora el rendimiento inmediato, sino que también garantiza que tu experiencia de juego se mantenga fluida y sin interrupciones a medida que los requisitos de los juegos aumenten con el tiempo. “Contar con más memoria permite ejecutar otras aplicaciones en segundo plano sin afectar la jugabilidad, como programas de streaming, grabación o navegadores web, lo que resulta en una experiencia más cómoda y versátil. En definitiva, invertir en 32 GB de RAM es una decisión inteligente para quienes buscan disfrutar de los videojuegos actuales y futuros con la máxima calidad y estabilidad”, concluye Daniels.

Para cualquiera que monte o actualice un PC para juegos en 2025 y en adelante, 32 GB de RAM DDR5 deberían considerarse el estándar, no un lujo opcional. Como los juegos modernos exigen más y los precios de la memoria son tan razonables, es una decisión inteligente que permitirá que su equipo funcione sin problemas durante muchos años.

Acer en redes sociales:

X: @Acer IG: AcerLatam FB: Acer LK: Acer

Por qué 32 GB de RAM debería ser el nuevo estándar para PC para juegos Leer más »